最近,谷歌的Gemini1.5和AI' >OpenAI的Sora模型引发热议,但这些模型是否真的能很好地理解世界?以Sora为例,虽然给人们带来了惊喜,但在模拟复杂物理原理方面存在一定局限性,如健身男子倒跑跑步机。随着大型模型的发展,固有的缺点也显现出来,模型在处理现实世界难以用语言描述的内容时表现困难,长程任务也难以处理。

因此,视频模型的出现在一定程度上弥补了这一问题,提供了语言和静态图像所缺少的时间信息,为大型语言模型(LLM)的发展带来新的可能性。然而,由于内存限制、计算复杂性和有限的数据集,从数百万个视频和语言序列的token中学习仍然具有挑战性。

项目地址:https://top.aibase.com/tool/large-world-models

为了解决这些挑战,来自UC伯克利的研究者推出了大世界模型(LWM),利用RingAttention技术对长序列进行可扩展训练,这是一个带有视频生成功能的多模态模型,非常强大,与Gemini1.5Pro的能力相当。这个模型支持100万上下文的文本检索,可以分析超过1小时的视频,并支持视频和图片生成。

该研究在长视频和语言序列上训练了一个具有极大上下文尺寸的transformers模型,为新的检索任务和长视频理解设立了新的标杆。

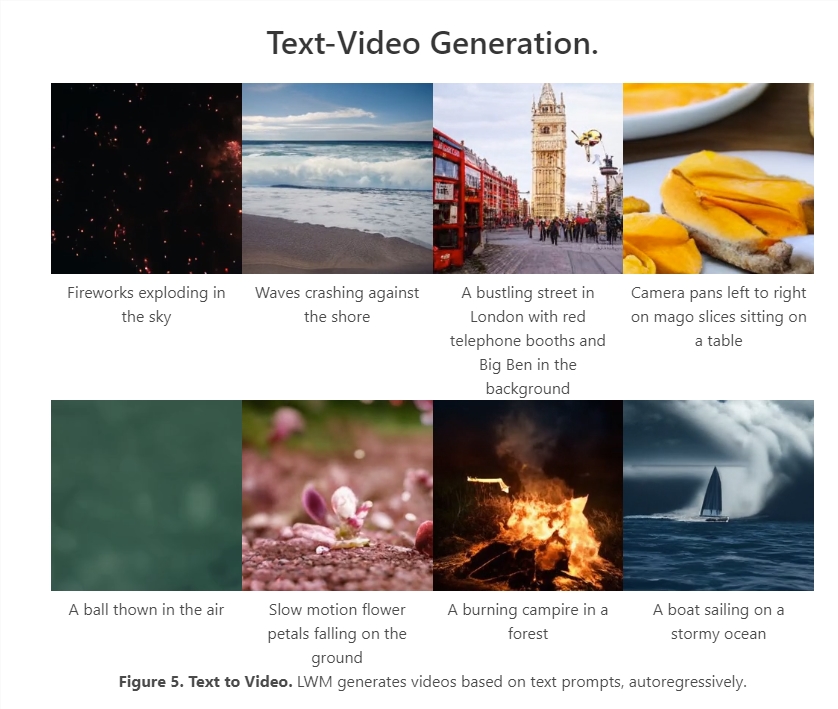

通过RingAttention、掩码序列打包等方法,研究团队成功训练了数百万长度的多模态序列,提供了处理超过100万token长文本文档和视频的完全开源模型。LWM模型不仅可以根据文本提示生成图像和视频,还能深入理解图片、回答关于图片的问题,表现出优越的长视频理解能力。

总的来说,LWM模型在长视频问题回答方面表现优于业界其他模型,包括谷歌的Gemini Pro和OpenAI的GPT-4。研究者通过多种策略克服了视觉-语言训练的挑战,为处理长视频与语言序列提供了新的思路,如损失加权和使用模型生成的问答数据。该研究的推出将为语言模型更好地理解物理世界打开新的可能性,为人工智能技术的发展带来新的契机。