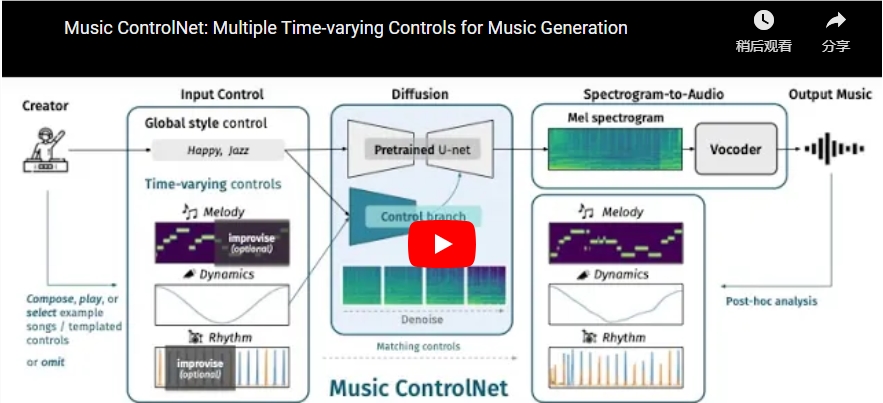

Music ControlNet是一款基于扩散(diffusion)技术的音乐生成模型,旨在为文本到音乐生成模型提供多个准确的、时变的音乐控制。虽然现代文本到音乐生成模型已经能够以广泛的风格生成高质量音乐,但文本控制主要适用于操纵全局的音乐属性,如流派、情绪和速度,对于精确控制音乐中时间变化的属性,比如节奏中的拍子位置或音乐动态的变化,则表现不佳。

项目地址:https://musiccontrolnet.github.io/web/

Music ControlNet通过提取训练音频中的控制信息,细调音乐的谱图生成模型,以给定旋律、动态和节奏控制的方式,实现对生成音频的多个准确时变控制。与已有的Uni-ControlNet方法相比,该模型引入了一种新的策略,允许创作者在时间上部分指定控制,从而为音乐创作提供更大的灵活性。

核心功能:

多时变控制: Music ControlNet为音乐生成提供多个时变的控制,包括旋律、动态和节奏,使创作者能够更精细地操控生成音乐的各个方面。

扩散技术: 采用扩散技术,通过对训练音频中提取的控制信息进行微调,实现对音频谱图的条件生成,提高生成音乐的质量和逼真度。

部分指定控制: 与传统模型相比,Music ControlNet引入了一种新的策略,允许创作者在时间上部分指定控制,为创作提供更大的自由度和创造性。

性能优越性: 在与MusicGen等现有音乐生成模型的比较中,Music ControlNet表现出色,生成的音乐与输入旋律的吻合度高达49%,同时具有更少的参数、更短的训练时间,以及对两种额外形式的时变控制的支持。

灵活的应用: 通过提供生成音乐的示例,包括旋律、动态和节奏的各种组合,以及对时间上部分指定控制的支持,Music ControlNet为创作者提供了丰富的工具,用于创作出具有多样性和创新性的音乐作品。